在3.18-3.21英伟达GTC大会上,英伟达CEO黄仁勋得到了流行明星式的追捧与崇拜。

GTC的第一天,黄仁勋如约发布了新一代Blackwell架构的芯片B200。与目前训练AI最强芯片H100相比,B200的训练性能提升4倍,推理性能提升30倍,售价在3-4万美元之间。在AI大模型的战场上,卖AI芯片的英伟达是最大的军火商,现在B200无疑是火力更猛的炮弹。

英伟达的芯片之路起起伏伏:靠游戏显卡打下最初的地盘,2007年进军移动芯片效果不佳,2016年以来拥抱加密货币、拥抱元宇宙,凭借加密货币的牛市,英伟达在2016-2018年市值攀升十倍,但也随着加密货币的寒冬而股价跳水。

2022年的秋天,美国芯片管制,挖矿时代终结。当英伟达当年11月财报显示显卡营收下滑、股价同比下跌近半时,没人能预料到,2022年11月底ChatGPT一声炮响,不仅引领了生成式AI的新浪潮,让全世界都认识了OpenAI,更是把军火商英伟达送上了神坛。

但黄仁勋自己预料到了,也一直在准备AI的爆发——2022年3月英伟达发布了H100芯片,距离OpenAI发布ChatGPT还有大半年,H100就专门针对AI大模型训练做了优化。

ChatGPT发布以来,英伟达股价一路上升。截至3月22日美股收盘,英伟达的市值已经超过了2.35万亿美元,排名全球上市公司市值第三,距离2.66万亿美元的苹果只有一步之遥。

但英伟达的AI芯片帝国并非牢不可破。英伟达GPU原本就不是专门为了AI训练而设计,而是在通用的图片处理器上叠加各种为AI训练适配的性能,相比之下,Groq的LPU、谷歌的TPU从底层设计上都更加AI专用化。

英伟达B200发布后,Groq团队(前谷歌TPU团队核心成员创立)在社交平台X上表示,自家的LPU芯片更快、功耗也更低;谷歌的TPU算力服务提供给了OpenAI的有力对手Anthropic;每年在数据中心上花费超500亿美元的微软,在联合AMD研发Maia 100 人工智能芯片;软银集团孙正义在撒钱造芯;3月21日三星宣布将在 2025 年初推出自己的人工智能加速器芯片。

但英伟达有自己的护城河——CUDA软硬件协同技术。GPU的并行计算能适用于大语言模型的多维张量计算,程序员写的代码本来只能运行在CPU上,但通过CUDA的程序接口,能运行在GPU上。CUDA发布于2006年,早期只有CUDA提供了对并行计算的支持,通过规模效应,CUDA已经成为行业标准。

就在GTC大会之前,英伟达试图禁止第三方公司兼容CUDA。这就像苹果的iOS系统一样,是英伟达最核心的护城河。

3月20日,就在英伟达GTC大会期间,美国商务部宣布向英特尔提供195亿美元激励,包括85亿美元资助和110亿美元贷款担保,美国政府想通过巨额补贴将近几十年来迁往亚洲的芯片产业引回美国。中国商务部发言人则在3月21号表示,中国欢迎全球半导体企业来华投资合作,共促产业链稳定。

尽管英伟达目前凭借GPU+NVlink+CUDA垄断了AI算力90%的市场,但在新的AI芯片公司想要弯道超车、变化诡谲的时局之下,英伟达还能保持自己的垄断吗?

先天缺陷、后天改良超车的GPU

AI芯片有多个技术路径。广义上讲,只要能运行人工智能算法的芯片都叫做AI芯片,但针对AI做了特殊加速设计的专用芯片效果会更好。

GPU原本是用做图形处理,不是专用于人工智能场景,从这点上看GPU是有先天缺陷的。但GPU因其并行计算的特点,适用于大语言模型的多维张量计算,一步步走上了为了AI而改造之路。

英伟达的改良方案很能担当起后来“核弹工厂”的称号:一方面堆砌算力、堆料。芯片的晶圆面积越做越大,从1997年的90平方mm到2015年之后的超过600平方mm。

英伟达也一直擅长多卡互联,通过两张或更多显卡互联工作的方式,以实现翻倍甚至是数倍于单张显卡的性能输出。最新Blackwell架构的B200芯片也是如此,它并不是传统意义上的单一GPU,而是由两个紧密耦合的芯片组成。在NVLink Switch高速互联技术支持下,英伟达“大力出奇迹”地将72块B200连接在一起,最终成为“新一代计算单元”GB200 NVL72,“批发打包”成数据中心来卖卡。

另一方面,通过“改良式创新”,来逐步解决GPU跟人工智能场景的不匹配问题。这些问题包括但不限于功耗、内存墙、带宽瓶颈、低精度计算、高速连接、特定模型优化……从2012年开始,英伟达加快了架构更新的速度,加上了各种针对AI训练的优化,如矩阵计算(Tensor Core 4.0)、提高精度、Transformer加速引擎等。

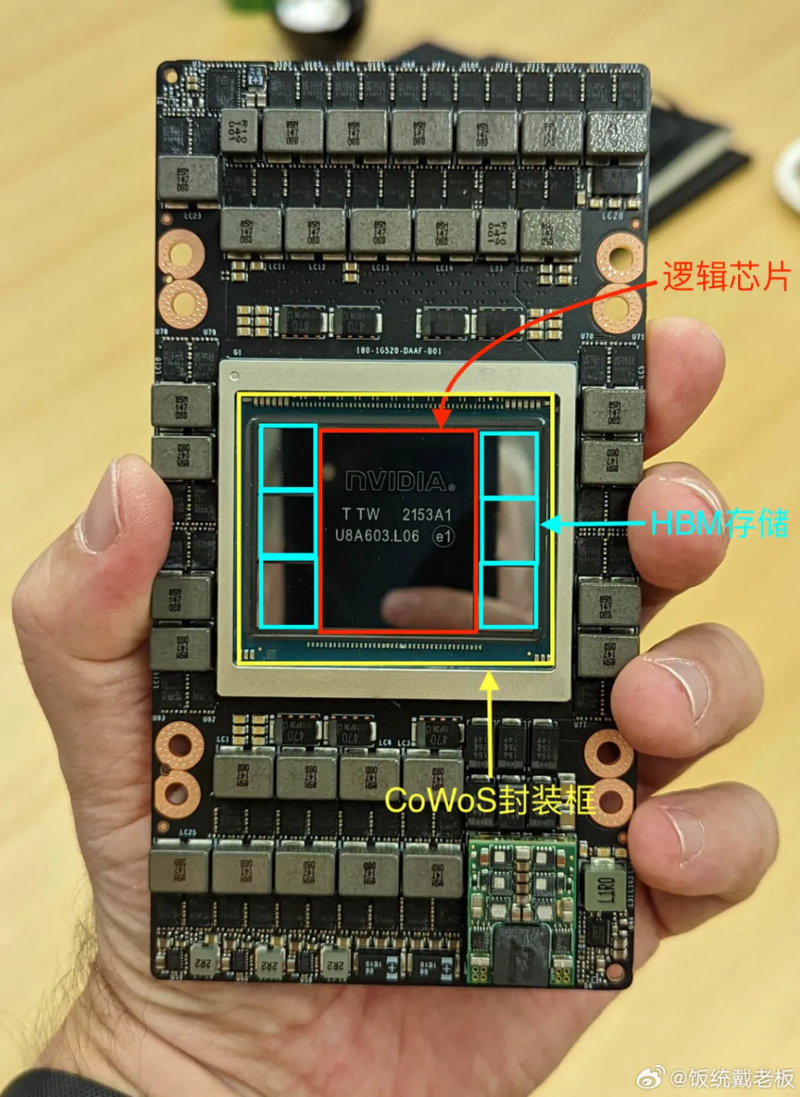

H100拆机图。图片来源:饭统戴老板

而且,英伟达一直在追赶时代浪潮,拥抱加密货币、拥抱元宇宙、拥抱AI,既追求提高算力、软硬件协同的长期主义,也追求在每一次浪潮中找准盈利点。据36Kr报道,2018 年,英伟达 CFO 公开披露了自己依靠销售“矿卡”赚钱的事实,黄仁勋则更是在发言中透露出了自己对“挖矿”的兴趣,“英伟达实际上对用户购买 GPU 的用途有所把控,我们必须留意它(用户买显卡来挖矿)的存在,并保证充足的库存来应对”。

据远川研究所报道,在生成式AI热潮之前,英伟达的毛利率常年维持在65%上下,而净利率通常只有30%。而今年Q2受高毛利的A100/A800/H100的拉动,毛利率站上70%,净利率更是高达45.81%。

专为AI而生的芯片:TPU和LPU

相比之下,谷歌的TPU和Groq的LPU都更加专为AI而生。

谷歌研发AI芯片其实比英伟达更早。2016年Google凭借AlphaGo战胜围棋冠军而惊艳世界,随后推出自研的专为AI而生的芯片TPU(Tensor Processing Unit),中文名叫做“张量处理单元”——“张量”即神经网络的基本单元,从芯片结构上就专为AI大模型训练设计。如果说英伟达对GPU的“魔改”是拆了东墙补西墙,那么TPU便是通过从根本上大幅降低存储和连接的需求,将芯片空间最大程度让渡给了计算。

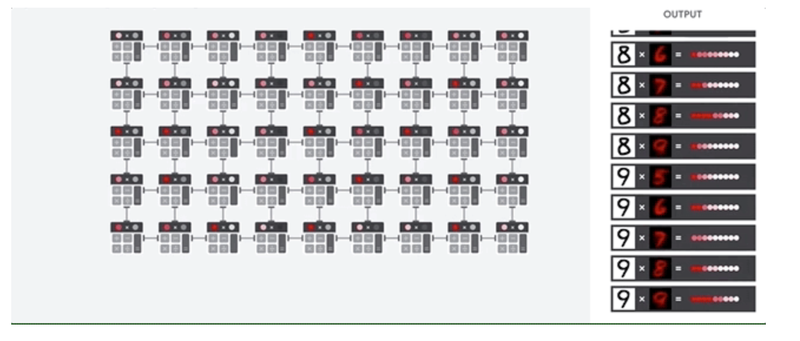

TPU计算原理图。图片来源:Google Cloud官网

TPU 的主要任务是矩阵处理,矩阵是乘法和累加运算的组合。神经网络运算需要进行大量矩阵运算,GPU只能按部就班将矩阵计算拆解成多个向量的计算,每完成一组都需访问内存,保存这一层的结果,直到完成所有向量计算,再将每层结果组合得到输出值。

而在TPU中,成千上万个计算单元被直接连接起来形成矩阵乘法阵列,作为计算核心,可以直接进行矩阵计算,除了最开始的加载数据和函数外无需再访问存储单元。这大大降低了访问频率,使得TPU的计算速度大大加快,能耗和物理空间占用也大大降低。

谷歌并不对外出售TPU芯片,它仍然是英伟达的大客户之一,并继续大批量采购英伟达的GPU。但谷歌把TPU其部署到自家的云服务系统中,对外(比如Anthropic公司)提供AI算力服务,这无疑压缩了英伟达的潜在市场。

而从谷歌TPU核心团队的离职人员,创建了Groq,其提出了一种全新的AI 芯片 LPU(Language Processing Unit,语言处理单元)。

作为创业公司,Groq这个团队更加锋芒锐利,扬言称要三年之内超过英伟达。在英伟达GTC期间,Groq也在X上各种正面硬刚英伟达:说自家的LPU芯片速度更快,功耗更低,即使英伟达有再多软件也无法克服硬件瓶颈,仅当芯片(指英伟达芯片)架构复杂且难以高效编程时,才需要 CUDA……其中“当芯片架构复杂且难以高效编程时,才需要 CUDA”可谓直指英伟达GPU本质上是个堆料改良“缝合怪”的痛点。

Groq在X平台上的发言。图片来源:X平台上Groq官方账号

LPU最夸张的指标是推理速度。运行开源大模型Mixtral 8×7B-32k,速度约为每秒500个token;切换到Llama 2-7B,速度为每秒750个token;而使用更大的Llama 2-70B,速度可以达到每秒300个token。

如果按照2个token相当于1个汉字的一般规律,那么使用英伟达H100芯片生成答案时,用户的阅读速度几乎可以跟上答案生成的速度,答案慢慢地展开下来。然而,使用 Groq 的芯片,生成答案就像用鼠标滚轮无意识地向下滚动网页一样快,页面眨眼间就过去了。

长期以来,芯片的HBM内存所需的封装技术被代工巨头台积电垄断,而Groq则避开适用HBM内存,转而使用SRAM内存。SRAM 的优势在于速度快、延迟低。Groq 的芯片搭载了230MB 的 SRAM 来保证内存带宽,片上内存带宽达到了 80TB/s。在算力层面,Gorq 芯片的整型(8位)运算速度为 750TOPs,浮点(16位)运算速度则为 188TFLOPs。

但Groq芯片是推理芯片,而不是训练芯片,不能用来训练大模型。

Groq虽然宣称自己芯片的功耗更低,但是从单位成本算力来看,Groq芯片并不便宜。

原 Meta 人工智能科学家、原阿里技术副总裁贾扬清做了一番估算,指出由于 Groq 的内存容量较小,在运行 LLaMa2 70B 模型时需要使用 305 张 Groq 卡,而使用 NVIDIA 的 H100 卡只需要 8 张。这相当于 Groq 的硬件成本大约是 H100 的 40 倍,而其能源成本则是 10 倍。

而世界上的云计算厂商(亚马逊AWS、微软Azure、Google Cloud、阿里云和IBM)都在加紧研发制造自己的AI芯片。其中,微软给芯片行业的冲击或许会最大。微软每年在数据中心上的支出超过 500 亿美元。据报道,微软正在研发自己的 Maia AI 服务器芯片,今年将安装在数据中心,其正在开发的新型网卡也可以提高Maia芯片的性能。

微软也在与英特尔联合起来造芯。据华尔街日报2月22日报道,微软首席执行官Satya Nadella在英特尔的一次活动上说,微软正在设计芯片,将在英特尔最先进的工厂之一制造。纳德拉没有具体说明英特尔将为其生产哪款芯片,但最近几个月微软一直在寻求加强芯片设计能力,包括去年推出的一款用于人工智能计算的新芯片。

真正的护城河——软硬一体的CUDA

科技界没有永远的巨头,但英伟达在加深自己的护城河——CUDA软硬件协同系统。

黄仁勋在GTC上宣称,英伟达其实是一家软件公司,为其他公司提供视觉计算核心技术,同时也是一家“综合性视觉计算和并行计算技术公司”。或许,黄仁勋对标的并不是芯片公司先驱,而是通过卖硬件来赚软件钱的苹果。

CUDA提供了平台性的接口,让程序员用C语言、C++等语言写的代码,通过CUDA翻译成能运行在GPU上的指令,让原本程序里的一行指令,变成GPU上几十万、几百万个并行的小处理单元。这样能让图形设计的游戏编程者和人工智能大模型的训练者更好地让GPU发挥作用。

CUDA发布于2007年,凭借着先行者地位和规模效应,CUDA成为深度学习领域事实上的垄断者。苹果在2009年推出OpenCL,这是一种开放标准,可用于对不同供应商的 CPU、GPU 和其他设备进行编程。但OpenCL在深度学习的生态上远不如CUDA,许多学习框架要么是在CUDA发布之后,才会去支持OpenCL,要么压根不支持OpenCL。苹果也没能动摇CUDA的地位。

而就在今年GTC大会之前,英伟达或许想扩大自己的垄断地位,开始禁止第三方硬件兼容CUDA。有用户发现,英伟达在其CUDA软件11.6及更高版本的最终用户许可协议中新增了一条禁止逆向工程、反编译或反汇编使用SDK生成结果,并在非英伟达平台上进行转译的规定。

在中国,摩尔线程、壁仞、华为都在开发自己的AI芯片,它们此前都是兼容CUDA接口的。

360集团创始人周鸿祎3月18号在视频上表示,以前国产芯片可以通过CUDA接口来在国产操作系统上运行软件,“为什么说我们国家的显卡希望能兼容CUDA,因为CUDA已经变成事实上的标准,如果能兼容CUDA,我们的国产操作系统(底层是Linux、底层芯片是华为芯片)的接口不用改变,就能兼容Windows,上面可以运行软件。”

但周鸿祎认为CUDA的护城河没有英伟达想象的那么深。周鸿祎呼吁,把推理芯片和训练芯片的研发分开,推理的难度要小于训练,英伟达的显卡适用于训练但用在推理上有些浪费,国产芯片商可以研发自己的推理芯片;在训练芯片上,鼓励国产芯片厂商可以积极加入国际上开源的训练框架,联合世界上其他的厂商(甚至包括苹果、AMD等),重新定义一个非CUDA的标准。

英伟达的CUDA系统垄断,加上美国愈发严格的芯片出口管制,会加强国产芯片自造一个生态系统的动力吗?

在美国针对英伟达又一轮出口管制发布后,2023年6月,英特尔专门把Gaudi 2芯片的发布会放在北京开,表示“帮助构建中国人工智能的未来”、“携手中国产业生态”,显然是想趁英伟达的缺位,进军中国市场。

结果2023年10月美国新版芯片出口管制发布,AMD的MI250X、MI300,英特尔的Gaudi 2、Gaudi 3和英伟达一起上了名单。

美国对中国的芯片出口管制越发严格,但所有人都知道,人工智能的时代已经不可避免地到来了。这种长期的封锁,长期的供不应求,必将加速中国芯片产业的自主研发。英伟达的AI芯片垄断地位,并不只靠它自身的技术实力和商业策略,或许也得看时运了。